AWS Deep Learning AMIを用いたGPU環境構築の手順

AWS Deep Learning AMIを用いたGPU環境構築の手順 今回はCUDAやcuDNN等の環境が予め構築されていて機械学習に適したインスタンスをかんたんに作成できるAWS Deep Learning AMIを […]

Filter by Category

今回はCUDAやcuDNN等の環境が予め構築されていて機械学習に適したインスタンスをかんたんに作成できるAWS Deep Learning AMIを利用してGPU環境を構築します。

インスタンスタイプ:g4dn.xlarge

OS:Ubuntu 18.04

AMI:Deep Learning AMI (Ubuntu 18.04) Version 53.0

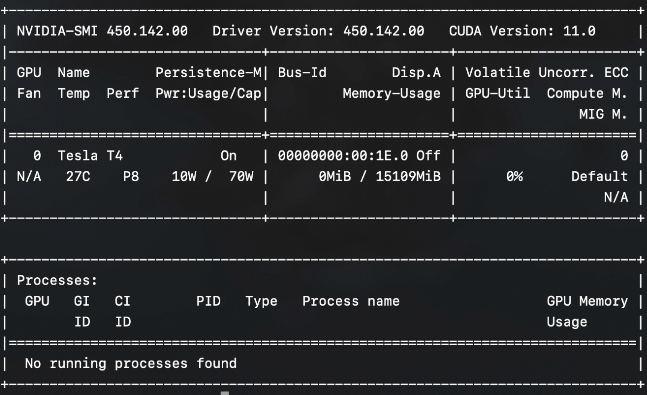

CUDA:11.0

EC2にはp系とg系の二種類のGPUインスタンスがありますが、今回はGoogle Colaboratoryでも使われている機械学習推論向けGPUでもあるNVIDIA T4が4個搭載されたG4 インスタンスを利用します。

G4 インスタンスにはg4ad.xlargeとg4dn.xlargeの2種類がありadがARMでdnがNVIDIAのGPUとなっています。

※4dn.xlargeを選ばないとGPUがNVIDIAにならないので注意

NVIDIAのGPUの情報は以下のコマンドで確認できます

nvidia-smi

Tsla T4が搭載されているのが確認できました。

Alembic API argparse Beautiful Soup black Channels charset CodeCommit datetime Django REST framework Docker enumerate f-string git GitHub glob Google Colaboratory i18n IAM Internship Jupyter Lambda Matplotlib Nginx OpenCV pandas PIL Pillow PostgreSQL PyCharm PyCon pyenv PyTorch Redis Rembg ReportLab requests S3 Sentry slack tqdm uWSGI venv Vue.js youtube

群馬県でPythonを使ったAIやソフトウェアを開発している株式会社ファントムが運営しています。

Comments